今天是《Google Seo,每天五分钟轻松学会》第十一课,主讲Google抓取工具。因为抓取是一个页面带来流量的起源,只有网站的页面被Google抓取工具抓取了,才有机会被索引,从而有排名,最后才能享受Seo优化带来的流量。

一、Google抓取工具原理

1、什么是Google抓取工具

Google抓取工具,也就是通常seo从业人员口中常说的,Spider(蜘蛛),Crawler(爬虫),为了让更多的人更好理解,通常会说Google抓取工具,也就是指Googlebot。

其实,Googlebot是一款程序,主要目的是帮助Google用来收集网页信息,并且把这些信息,分类存储到相应的数据库,索引。

也就是你在Google搜索相关内容时,展示出来的搜索结果,都是Googblebot这个像蜘蛛、爬虫一样的抓取工具,在无数的网页上一点点抓取,分类索引,最后检索出来的。

2、Googlebot工作原理

Googlebot虽然是一款程序,那么它办事(抓取网页)就一定会按程序(规矩)来,这里的规矩就是robot.txt。

假设目前它需要去抓取一个网站,首先它会浏览robot.txt的文件,这个文件会告诉所有的爬虫,包括Google,百度,Bing等等,哪些爬虫能抓取,哪些爬虫禁止抓取,哪些文件能抓取,哪些文件不能抓取等等,当然,这个robot.txt都是我们可以编辑的,这里面不细讲,后面的课程会着重讲解,这里你只需要知道robot.txt是写给所有搜索引擎爬虫看的,并且所有爬虫去一个网站第一个访问的就是这个文件,并且按规矩办事即可。

有些特殊情况的抓取工具,可以不看规矩(robot.txt)办事!例如下面Googlebot类别中的一些特殊情况。

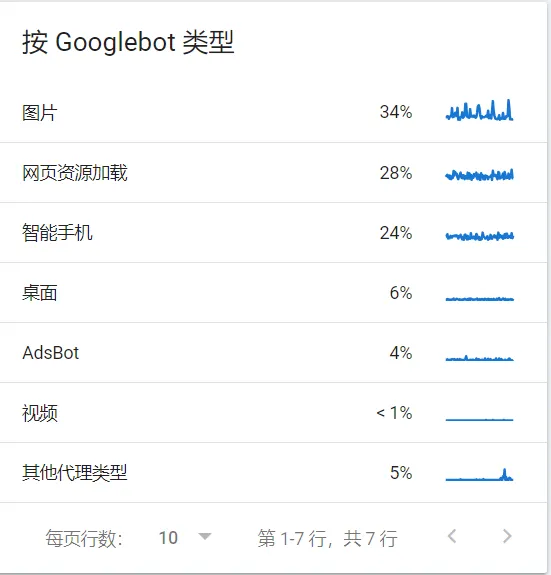

3、Googlebot类别

Googlebot为了更好的索引网络上的文件资源,它有大量的爬虫,同时有不同类型分别对应相应文件去进行抓取,分类,索引。

①、按访问端口分

Googlebot可分为移动端和PC端

②、按文件类型分

Googlebot可根据不同文件类型分类,主要有

抓取新闻:Googlebot News

抓取图片:Googlebot Image

抓取视频:Googlebot Video

抓取商品:Storebot Google

③、其他常用分类

Google other:帮助Google其他产品团队从网站抓取内容的通用抓取工具

Google-InspectionTool:是Google Search Console 中的搜索测试工具所使用的抓取工具。

④、不看robot.txt规则的抓取工具

APIs-Google:是Google API用于传递推送通知消息的用户代理工具。

AdSense和Mobile AdSense:该抓取工具主要通过访问网站的内容,来提供相应内容的广告,分别为pc端和移动端。

AdsBot和AdsBot Mobile Web:该抓取工具主要检测网页广告的质量,同样也分为pc端和移动端。

Google-Safety:负责处理针对在Google产品和服务进行滥用行为的抓取工具。

二、玩转Google抓取工具

1、如何主动提交抓取

主要方法有两种:

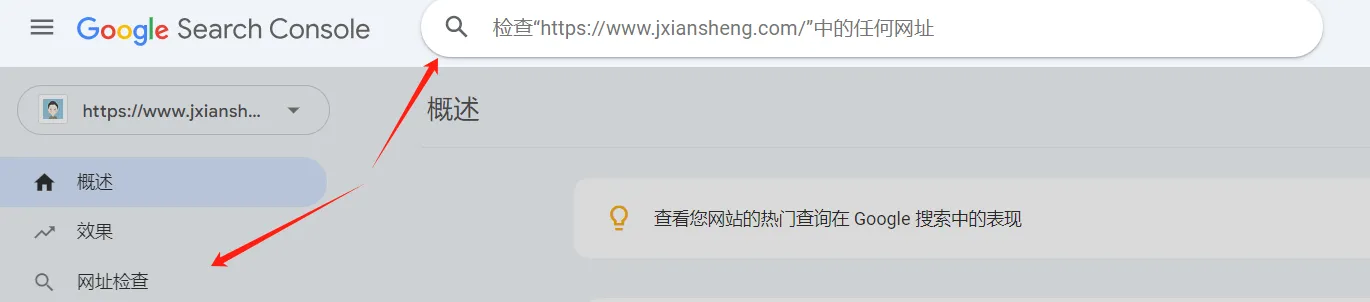

①、通过Google Search Console的网址检查工具提交。

操作如下图

这种方法比较适合新增更新的网页数量不多,而且这种提交方法有数量限制,并且多次请求重新抓取同一网址并不会缩短对该网址的抓取时间,所以以后提交了没被收录,不要着急,也不用再次提交!

②、通过站点地图提交

这种方法比较适合大量网址页面新增及更新,同时可以包含页面的多种文件类型。

关于网站地图的使用,详细可以查看上一节课的内容。

第十课:网站地图全面解析-《Google Seo,每天五分钟轻松学会》

2、如何控制Googlebot抓取速度

一般来说,我们都是希望Googlebot抓取速度是快的,而且越快越好,甚至希望刚发布的内容页面就能马上被Google抓取,索引,从而获取流量。

所以,我们需要先了解影响Googlebot抓取页面的因素有哪些,然后在根据自己需求来进行调整。

①、Googlebot影响因素

Googlebot每次抓取网站时,是在不过多使用服务器带宽的情况下,尽可能多的抓取网页,同时会根据自己的算法,来确定抓取我们网站的速度。

所以,Googlebot抓取网站页面是受服务器带宽、响应速度,时间,相应资源所决定。

②、如何加快Googlebot抓取速度

既然我们知道了影响因素,那我们就可以针对性调整。

I、优化服务器配置,减少服务器响应时间

II、优化网页JS,减少网页渲染时间

III、合理运用robot.txt规则抓取相关页面

IV、减少重复页面和错误页面

总结:优化网页和服务器,让Googlebot在有限的时间内,抓取更多的页面。

③、如何减缓Googlebot抓取速度

首先我们来思考一个问题,当Googlebot每天都正常抓取你网站的内容时,遇到什么情况才会让它抓取工作直接受阻呢?

5,4,3,2,1...

我相信很多小伙伴已经想到答案了!

就是当网页出现问题的时候

因为Googlebot发现网站出现了问题,会立即减少对该网站的抓取,以免抓取索引后,给用户检索访问带来不好的体验。

所以,如果你需要在短时间(两天之内)内减慢抓取速度,可以通过修改服务器配置文件或者程序代码,把抓取请求返回 500(服务器内部错误)、503 (服务器当前不可用,服务器维护,更新,超载)或 429(客户端请求过多,超过了服务器处理能力)HTTP响应状态代码。

Googlebot在遇到以上这些情况,或者整个网站访问不了时,Googlebot 会立即减慢对网站的抓取速度。

改善方法:2天内,重新调整回来,减少这些错误的数量,抓取速度会慢慢重新开始提升。

建议:因为抓取速度减慢不仅会影响已经被索引的设置页面,还会影响整个网站及用户体验,非特殊必要(如Googlebot抓取过度,造成服务器负载严重过重等),不要采取减缓抓取速度措施。而且,不要超过2天,否则会导致Google从索引中移除这些页面网址,并且有可能永久减慢抓取速度或者停止抓取该网址。

PS:如果你以前知道或者通过早期的内容了解到抓取速度限制器这个工具时,和你分享个最新消息,在2024年1月8日,Google Search Console已经弃用了抓取速度限制器这个工具,所以让我们把更多精力放在网站本身以及服务器上会更好。

3、如何禁止Googlebot抓取

在robots.txt可以设置允许或者禁止Googlebot抓取某些网站或者页面规则。

代码参考:

禁止Googlebot抓取整站:

User-agent: Googlebot

Disallow: /

禁止Googlebot抓取某个栏目/页面

User-agent: Googlebot

Disallow: /example

三、什么是抓取预算

1、抓取预算定义

首先,我们需要知道网络上有无数个网站及相关页面,并且每一天每一秒都在增加,Googlebot需要花费大量的时间和相应的资源,去抓取页面,那么所消耗的这些时间和资源,就是Googlebot的抓取预算。

同时,每个网站的抓取预算是不一样的,抓取预算由两个主要元素决定:抓取容量上限和抓取需求。

2、抓取需求

Google在抓取网站时会根据网站的规模、更新频率、网页质量,以及相关内容的高质量外链等因素来了解网站的抓取需求,并且根据这些需求来分配抓取该网站的时间。

3、抓取容量上限

Googlebot在抓取网站时,为了可以更多抓取网站的所有重要内容,同时又不影响服务器负载过重,所以Googlebot会计算抓取容量上限,也就是Googlebot最多可以使用多少同时载入的并行连接来抓取网站,以及各次抓取之间的时间延迟。

因此,网站的响应式速度越快,那么Googlebot抓取页面时就会越顺畅,抓取速度也会越快,那么Google就可以使用更多的资源去抓取它。

所以,抓取容量上限是会随着网站响应速度而变化。

总结:增加网站内容更新频率,加快网站响应式度以及高质量的内容产出,配合与网站相关的高质量外链,可以有效的增加Googlebot的抓取预算。

今天就分享到这里,期待能帮助你!

留言(如有建议/友链/合作等需求可在此处留言,会尽快回复,谢谢!)